تحقیقات پیشرفته نشان میدهند که زبان برابر با هوش نیست. تمام حباب هوش مصنوعی بر نادیدهگیری این موضوع ساخته شده است.

«توسعه هوش فوقالعاده اکنون در دسترس است»، مارک زاکربرگ میگوید و به «ایجاد و کشف چیزهای جدیدی که امروز قابل تصور نیستند» اشاره میکند. هوش مصنوعی قدرتمند «ممکن است تا سال ۲۰۲۶ ظاهر شود و در اکثر حوزههای مرتبط از یک برنده جایزه نوبل هوشمندتر باشد»، داریو آمودی میگوید و دو برابر شدن طول عمر انسان یا حتی «سرعت گریز» از مرگ را پیشبینی میکند. «ما اکنون اطمینان داریم که میدانیم چگونه AGI را بسازیم»، سام آلتمن میگوید، که به هدف مقدس صنعت یعنی هوش مصنوعی عمومی اشاره دارد — و به زودی هوش فوقالعاده میتواند «پیشرفت علمی و نوآوری را به مراتب فراتر از تواناییهای خودمان سرعت بخشد».

آیا باید به آنها باور کنیم؟ نه، اگر به علم هوش انسانی اعتماد کنیم و فقط به سامانههای هوش مصنوعی که این شرکتها تاکنون تولید کردهاند، نگاه کنیم.

ویژگی مشترکی که بین چتباتهای OpenAI (ChatGPT)، Anthropic (Claude)، Google (Gemini) و هر نامی که متا این هفته برای محصول هوش مصنوعیاش انتخاب کرده، وجود دارد، این است که همه آنها بهطور عمده «مدلهای زبان بزرگ» هستند. در اصل، این مدلها بر پایه جمعآوری مقدار فوقالعادهای از دادههای زبانی (بخش بزرگی از آنها در اینترنت کدگذاری شدهاند)، یافتن همبستگیها بین واژهها (در دقیقتر، زیرواژگانی که «توکن» نامیده میشوند) و سپس پیشبینی خروجی بر پایه یک پرامپت ورودی خاص عمل میکنند. با تمام پیچیدگی ادعایی هوش مصنوعی مولد، در هسته خود اینها در واقع مدلهای زبانی هستند.

مسئله این است که بر اساس نوروساینس کنونی، تفکر انسانی تا حد زیادی مستقل از زبان است — و دلیل کمی برای این داریم که مدلسازی پیشرفتهتر زبان بتواند شکلی از هوش ایجاد کند که با هوش ما برابر یا فراتر باشد. انسانها از زبان برای انتقال نتایج توانایی استدلال، شکلگیری انتزاع و تعمیمهای خود استفاده میکنند، یا همان هوشی که ما داریم. ما از زبان برای فکر کردن استفاده میکنیم، اما این به معنای ساختن معادل زبان با فکر نیست. درک این تمایز کلید جدا کردن حقیقت علمی از علمیتخیلینویسهای CEOهای پرشتاب هوش مصنوعی است.

دستگاه پرزرقوبرق هوش مصنوعی بیوقفه این ایده را ترویج میدهد که ما در آستانه خلق چیزی به هوش انسانی یا حتی «هوش فوقالعاده» هستیم که ظرفیتهای شناختی ما را به طرز چشمگیری پشت سر میگذارد. اگر ما دادههای فراوانی درباره جهان جمعآوری کنیم و این را با توان محاسباتی قدرتمند (خواندن: چیپهای Nvidia) ترکیب کنیم تا همبستگیهای آماری خود را بهبود ببخشیم، در آن صورت بهسراسر AGI خواهیم داشت. مقیاسپذیری همان چیزی است که نیاز داریم.

اما این نظریه بهطور جدی علمی دچار نقص است. LLMها صرفاً ابزارهایی هستند که کارکرد ارتباطی زبان را شبیهسازی میکنند، نه فرآیند شناختی متمایز تفکر و استدلال، صرفنظر از تعداد مراکز دادهای که میسازیم.

ما از زبان برای فکر کردن استفاده میکنیم، اما این ساختن زبان را معادل فکر نمیسازد.

سال گذشته، سه دانشمند مقالهای در مجله Nature با عنوان واضح «زبان عمدتاً ابزاری برای ارتباط است نه برای تفکر» منتشر کردند. این مقاله توسط اوولینا فدورینکو (MIT)، استیون پیانتادوزی (UC Berkeley) و ادوارد ایاف. گیبسون (MIT) تألیف شده است و خلاصهای از دههها پژوهش علمی درباره رابطه زبان و فکر است. هدف آن دو برابر است: اول، رد این تصور که زبان باعث توانایی تفکر و استدلال میشود؛ دوم، تأکید بر اینکه زبان بهعنوان ابزار فرهنگی برای بهاشتراکگذاری افکار بین افراد تکامل یافته است.

بیایید هر یک از این ادعاها را جداگانه بررسی کنیم.

وقتی به تفکر خود میاندیشیم، گاهی این احساس را داریم که در «زبانی» خاص فکر میکنیم و بنابراین به دلیل همان زبان. اما اگر زبان برای فکر ضروری بود، حذف زبان باید توانایی فکرکردن را نیز از بین ببرد. این اتفاق نمیافتد. من این را بارها میگویم: حذف زبان، توانایی تفکر ما را از بین نمیبرد. و این را به دلایل تجربی میدانیم.

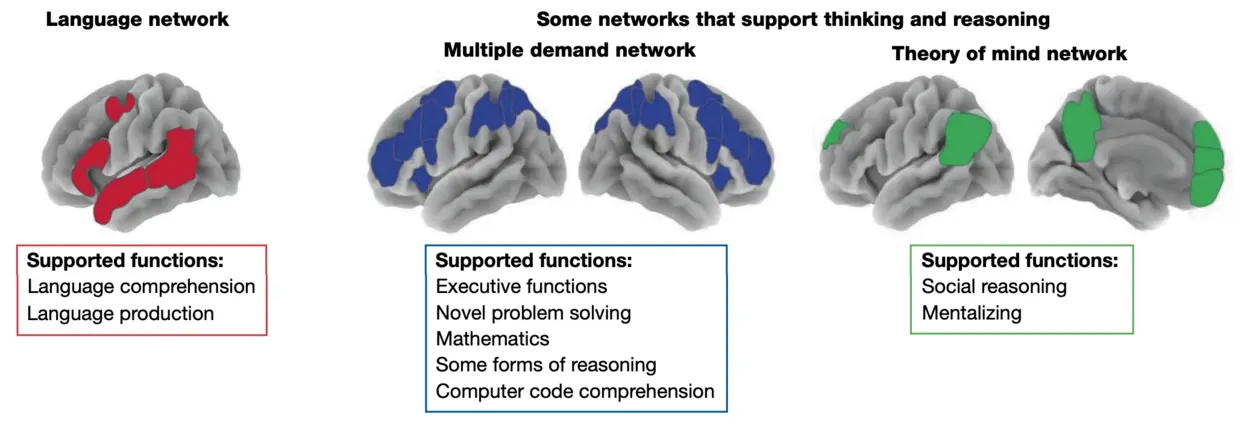

نخست، با استفاده از تصویربرداری رصدی عملکردی مغناطیسی (fMRI) میتوانیم بخشهای مختلف مغز را هنگام انجام فعالیتهای ذهنی متفاوت ببینیم. همانطور که پیداست، زمانی که بهکارهای شناختی مختلفی میپردازیم — مثلاً حل یک مسأله ریاضی یا درک آنکه در ذهن دیگری میگذرد — بخشهای متفاوتی از مغز «روشن میشوند» که بخشی از شبکههایی جدا از توانایی زبانی ما هستند:

دوم، مطالعات بر روی افرادی که بهدلیل آسیب مغزی یا سایر اختلالات توانایی زبانی خود را از دست دادهاند، بهوضوح نشان میدهد که این فقدان بهطور اساسی توانایی تفکر کلی را مختل نمیکند. «شواهد واضح است»، فدورینکو و همکاران میگویند که «موارد متعددی از افراد با نقص شدید زبانی وجود دارد که با اینحال تواناییهای فکری متنوعی همچون حل مسایل ریاضی، دنبال کردن دستورهای غیرکلامی، درک انگیزههای دیگران و استدلال — شامل استدلال منطقی رسمی و علتمربوط به جهان — را حفظ میکنند.»

اگر میخواهید خودتان این موضوع را بررسی کنید، یک روش ساده این است: بچهای را پیدا کنید و به او نگاه کنید (وقتی که خواب نیست). شما مطمئناً یک نوزاد کوچک را میبینید که با کنجکاوی دنیای اطرافش را کشف میکند، با اشیا بازی میکند، صدا ایجاد میکند، چهرهها را تقلید میکند و از طریق تعاملها و تجربهها یاد میگیرد. «مطالعات نشان میدهند که کودکان همانند دانشمندان، از طریق آزمایش، تجزیه و تحلیل آمار و شکلگیری نظریههای شهودی دربارهٔ حوزههای فیزیکی، زیستی و روانشناختی، دنیای اطراف را میآموزند»، آلایسون گپنیک، روانشناس شناختی، میگوید، و این همه پیش از یادگیری گفتار اتفاق میافتد. نوزادان شاید هنوز نتوانند از زبان استفاده کنند، اما قطعاً فکر میکنند! و هر والدینی خوشحال میشود که شاهد ظهور شناخت کودک خود در طول زمان باشد، حداقل تا دوران نوجوانی.

پس، از دیدگاه علمی، زبان تنها یکی از جنبههای تفکر انسانی است و بخش زیادی از هوش ما شامل تواناییهای غیرزبانی است. پس چرا بسیاری از ما بهصورت غریزی این تصور را داریم که زبان معادل هوشمندی است؟

این سؤال ما را به ادعای دوم مقاله Nature فدورینکو و همکاران میبرد، که میگوید زبان عمدتاً ابزاری است که برای بهاشتراکگذاری افکار بین یکدیگر استفاده میکنیم — «کد ارتباطی کارآمد» به قول آنها. این در این واقعیت مشهود است که میان گوناگونی زبانهای انسانی ویژگیهای مشترکی وجود دارد که آنها را «آسان برای تولید، آسان برای یادگیری و درک، مختصر و کارآمد برای استفاده و مقاوم در برابر نویز» میکند.

حتی بخشهایی از صنعت هوش مصنوعی در حال انتقاد از LLMها هستند.

بدون ورود عمیق به جزئیات زبانی، نتیجه این است که انسانها بهعنوان گونهای از موجودات، از استفاده از زبان برای بهاشتراکگذاری دانش ما، چه در زمان حال و چه در میان نسلها، بهطرز چشمگیری بهرهمند میشوند. از این منظر، زبان همان چیزی است که روانشناس شناختی سسیلیا هیز «گجت شناختی» مینامد و «به انسانها امکان میدهد تا با کارایی، وفاداری و دقت فوقالعادهای از یکدیگر یاد بگیرند.»

شناخت ما بهبود مییابد بهدلیل زبان — اما توسط آن ساخته یا تعریف نمیشود.

اگر توانایی گفتار ما را بگیریم، هنوز میتوانیم فکر کنیم، استدلال کنیم، باورهایمان را شکل دهیم، عاشق شویم و در جهان حرکت کنیم؛ دامنهٔ آنچه میتوانیم تجربه کنیم و دربارهاش فکر کنیم همچنان وسیع است.

اما اگر زبان را از یک مدل زبانی بزرگ بگیریم، در واقع هیچ چیزی نداریم.

یک طرفدار هوش مصنوعی ممکن است استدلال کند که هوش سطح انسانی لزوماً نیازی به عملکرد مشابه با شناخت انسانی ندارد. مدلهای هوش مصنوعی در فعالیتهایی مانند شطرنج پیشی گرفتهاند با استفاده از فرآیندهایی که با کار ما متفاوت است، پس شاید بتوانند با روش خاصی از کشف همبستگیها در دادههای آموزشی، به هوش فوقالعاده برسند.

شاید! اما دلیل واضحی برای این که بتوانیم به هوش «عمومی» برسیم — نه فقط بهبود وظایف محدود — از طریق آموزش مبتنی بر متن نداریم. در نهایت، انسانها اطلاعاتی دارند که بهسختی میتوان در دادههای زبانی خلاصه کرد — و اگر در این مورد شک دارید، بهخاطر داشته باشید که چطور میتوانید دوچرخهسواری را یاد بگیرید.

در واقع، در جامعهٔ پژوهش هوش مصنوعی آگاهی در حال رشد است که LLMها بهتنهایی مدلهای کافی برای هوش انسانی نیستند. برای مثال، یان لوکون (برنده جایزه تورینگ برای پژوهشهای هوش مصنوعی و شکاک برجسته LLMها) هفته گذشته نقش خود را در متا رها کرد تا استارتاپی برای هوش مصنوعی راهاندازی کند که به «مدلهای جهانی» پردازد: «سیستمهایی که جهان فیزیکی را درک میکنند، حافظهٔ مداوم دارند، میتوانند استدلال کنند و برنامهریزی برای توالیهای پیچیدهٔ اقدام داشته باشند.» بهتازگی، گروهی از دانشمندان برجسته هوش مصنوعی و «متفکران» — از جمله یوشوا بنگیو (برنده جایزه تورینگ دیگر)، اریک اشمیت (سابق مدیرعامل گوگل) و گاری مارکوس (شکاک هوش مصنوعی) — دربارهٔ تعریف کاری AGI بهعنوان «هوش مصنوعی که میتواند با تواناییهای شناختی تنوع و مهارت یک بزرگسال تحصیلکرده مطابقت داشته یا فراتر رود» (تاکید اضافه) توافق کردند. بهجای نگاه به هوش بهعنوان «قابلیت تکمولفهای»، آنها پیشنهاد میکنند بهدست آوردن مدل شناختی انسانی و مصنوعی که «معماری پیچیدهای ترکیبی از تواناییهای متمایز» را منعکس میکند.

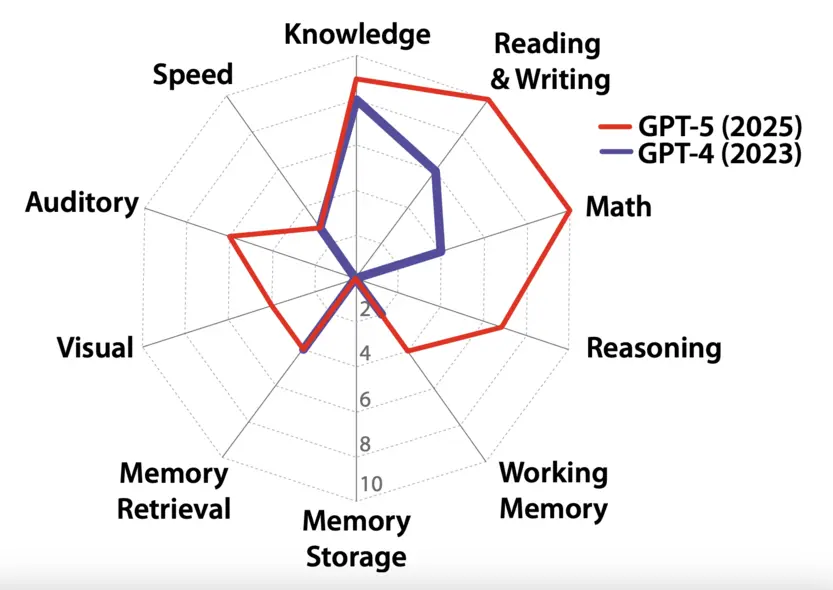

آنها استدلال میکنند هوش شبیه به این است:

آیا این پیشرفت است؟ شاید، تا جایی که این حرکت ما را از جستجوی مزهدار برای بهدست آوردن دادههای بیشتر برای سرورهای ریک میبرد. اما هنوز مشکلاتی وجود دارد. آیا میتوانیم واقعاً تواناییهای شناختی فردی را جمعکنیم و مجموع آن را بهعنوان هوش عمومی تعریف کنیم؟ وزندهی این تواناییها و اینکه چه تواناییهایی را بگنجانیم یا حذف کنیم چگونه باشد؟ دقیقاً چه معنایی از «دانش» یا «سرعت» میدهیم و در چه زمینهای؟ و در حالی که این کارشناسان توافق دارند که مقیاسپذیری مدلهای زبانی آنها را به هدف نمیرساند، مسیر پیشنهادی آنها پراکنده است — هدفی واضحتر میسازند، نه یک نقشهٔ راه برای رسیدن به آن.

بههر حال، فرض کنیم که در آیندهٔ نزدیک بتوانیم سیستمی هوش مصنوعی بسازیم که در گسترهٔ وسیعی از وظایف شناختی چالشبرانگیز همانند این نمودار مارپیچی بهخوبی عمل کند. آیا موفق خواهیم شد سیستمی بسازیم که هوشی داشته باشد که منجر به کشفیات علمی تحولآفرین مانند تعهدات بزرگتکنولوژیمدیران شود؟ لزوماً نه. زیرا مانع نهایی این است که حتی بازآفرینی نحوهٔ تفکر فعلی انسان، تضمین نمیکند که سامانههای هوش مصنوعی بتوانند جهشهای شناختی را همانند انسانها انجام دهند.

ما میتوانیم از توماس کوهن و کتاب او The Structure of Scientific Revolutions برای مفهوم «پارادایمهای علمی» که چارچوبهای اساسی برای درک جهان در هر زمان هستند، تشکر کنیم. او استدلال کرد که این پارادایمها «تحول» میکنند نه بهدلیل آزمایش تکراری، بلکه وقتی سؤالها و ایدههای جدیدی ظاهر میشوند که دیگر در چارچوب علمی موجود جای نمیگیرند. برای مثال، اینشتین پیش از اینکه شواهد تجربی آن را تأیید کنند، نظریه نسبیت را بهوجود آورد. پیرو این نگرش، ریچارد رورتی استدلال میکرد که زمانی که دانشمندان و هنرمندان از پارادایمهای موجود (یا همان واژگان) خسته میشوند، آنها «متافورهای جدیدی» میآفریند که توصیفهای نوین جهان را میسر میسازند — و اگر این ایدهها مفید باشند، تبدیل به درک عمومی از حقیقت میشوند. بهاین ترتیب، او گفت «حس عامالمنطقی مجموعهای از متافورهای مرده است.»

بهنظر میرسد که سیستم هوش مصنوعی که در حوزههای شناختی چندگانه کار میکند، میتواند پیشبینیهایش را بر پایهٔ جمعآوری الکترونیکی دادههای موجود بهصورت انسانی شبیهسازی کند. این پیشبینیها میتوانند حتی پارادایمهای جدید را به مدلشان اضافه کنند بهصورت شبیهساز انسان. اما این سیستمها دلایل واضحی برای عدم رضایت از دادههای خود ندارند — و بدیهی است که بهسوی جهشهای علمی و خلاقانهٔ عظیم پیشنروند نخواهند رفت.

در عوض، واضحترین نتیجهٔ ممکن، فقط یک مخزن «حس عام» خواهد بود. بله، سیستم هوش مصنوعی میتواند دانشمان را به شکلهای جالب ترکیب و بازآفرینی کند. اما این همان چیزی است که میتواند انجام دهد. آن برای همیشه در واژگانی که در دادههایمان کدگذاری شده است، در یک ماشین «متافور مرده» محبوس خواهد ماند — و انسانهای واقعی — که فکر میکنند، استدلال میکنند و زبان را برای ارتباط افکار استفاده میکنند — در ردهٔ پیشرو برای تحول درک ما از جهان باقی میمانند.

Benjamin Riley مؤسس Cognitive Resonance، یکسرمایهگذاری جدید برای کمک به مردم درک هوش انسانی و هوش مصنوعی مولد. برخی بخشهای این مقاله ابتدا در Cognitive Resonance Substack منتشر شدهاست.