گوگل شتابدهنده جدیدی برای LiteRT معرفی کرده است که به نام Qualcomm AI Engine Direct (QNN) شناخته میشود و هدف آن ارتقای عملکرد هوش مصنوعی داخل دستگاه در دستگاههای اندروید مجهز به پردازندههای Snapdragon 8 تولید شده توسط Qualcomm است. این شتابدهنده بهبودهای چشمگیری ارائه میکند که سرعت اجرای کارها را تا ۱۰۰برابر نسبت به CPU و ۱۰ برابر نسبت به GPU افزایش میدهد.

اگرچه سختافزار GPU در دستگاههای اندروید مدرن بهطور گستردهای موجود است، اتکا به آن بهطور انحصاری برای کارهای هوش مصنوعی میتواند باعث ایجاد گلوگاههای عملکردی شود، بهگفته مهندسان نرمافزار گوگل، لو وانگ، وی‑یی وانف و اندرو وانگ. برای مثال، آنها اشاره کردند که «اجرای یک مدل تولید تصویر از متن با محاسبه سنگین بر روی دستگاه، در حالی که همزمان جریان زنده دوربین را با تقسیمبندی مبتنی بر یادگیری ماشین پردازش میکند» میتواند حتی GPUهای سطح بالای موبایل را نیز تحت فشار قرار دهد. نتیجه میتواند تجربه کاربری پر جنجال و از دست رفتن فریمها باشد.

با این حال، امروزه بسیاری از دستگاههای موبایل شامل واحدهای پردازش عصبی (NPU) هستند که شتابدهندههای هوش مصنوعی سفارشیطراحیشدهاند و میتوانند نسبت به GPU بارهای کاری هوش مصنوعی را به طور قابلتوجهی تسریع کنند، در حالی که مصرف انرژی کمتری دارند.

QNN توسط گوگل با همکاری نزدیک با Qualcomm توسعه یافت تا جایگزینی برای نماینده قبلی TFLite QNN باشد. این ابزار جریان کاری یکتا و سادهای را برای توسعهدهندگان فراهم میکند از طریق ادغام مجموعه گستردهای از کامپایلرها و زمانهای اجرا (runtime) بر روی SoC و در اختیار قراردادن آنها از طریق یک API یکپارچه. این سامانه از ۹۰ عمل LiteRT پشتیبانی میکند با هدف امکانپذیر کردن واگذاری کامل مدل، که عامل کلیدی برای دستیابی به عملکرد بهینه است. QNN همچنین شامل هستهها و بهینهسازیهای تخصصی است که عملکرد مدلهای زبانی بزرگ (LLM) مانند Gemma و FastLVM را بیشتر میسازد.

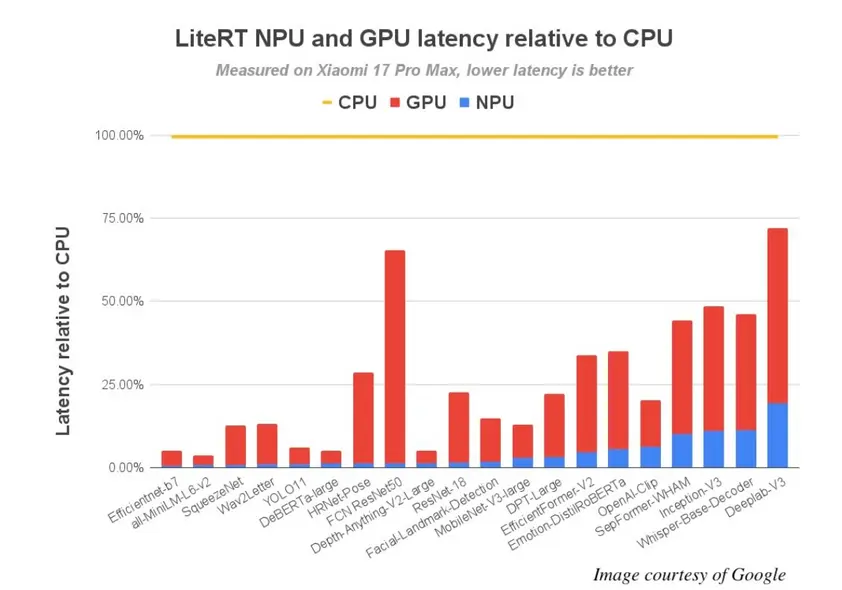

گوگل آزمون عملکرد QNN را بر روی ۷۲ مدل یادگیری ماشین انجام داد که ۶۴ مورد از آنها با موفقیت بهواگذاری کامل به NPU دست یافتند. نتایج نشان دادند که بهبود عملکرد تا ۱۰۰ بار نسبت به اجرا بر روی CPU و ۱۰ بار نسبت به GPU به دست آمده است.

در پرچمدار جدید SoC شرکت Qualcomm، Snapdragon 8 Elite Gen 5، مزیت عملکردی چشمگیر است: بیش از ۵۶ مدل در کمتر از ۵ میلیثانیه با NPU اجرا میشوند، در حالی که تنها ۱۳ مدل این سرعت را بر روی CPU دارند. این امر دسترسی به مجموعهای وسیع از تجربیات هوش مصنوعی زنده را که پیش از این دسترسناپذیر بودند، امکانپذیر میسازد.

مهندسان گوگل همچنین یک برنامه مفهومی را توسعه دادند که از نسخههای بهینهسازیشدهٔ مدل رمزگذاری بینایی FastVLM‑0.5B اپل استفاده میکند. این برنامه میتواند صحنه زندهٔ دوربین را تقریباً بلافاصله تفسیر کند. بر روی NPU Snapdragon 8 Elite Gen 5، این برنامه زمان تا اولین توکن (TTFT) شگفتانگیزی برابر ۰٫۱۲ ثانیه برای تصاویر با ابعاد ۱۰۲۴×۱۰۲۴ بهدست میآورد، بیش از ۱۱ 000 توکن در ثانیه برای پر فِل و بیش از ۱۰۰ توکن در ثانیه برای رمزگشایی. مدل اپل با کمینهسازی وزن به صورت int8 و کمینهسازی فعالسازی به صورت int16 بهینهسازی شده بود. به گفتهٔ مهندس گوگل، این کلید باز کردن قفل هستههای پرسرعت int16 قدرتمند NPU است.

QNN تنها از زیرمجموعه محدودی از سختافزارهای Android پشتیبانی میکند، عمدتاً دستگاههایی که با SoCهای Snapdragon 8 و Snapdragon 8+ مجهز هستند. برای شروع، راهنمای شتابدهی NPU را بازدید کنید و LiteRT را از GitHub دریافت کنید.