چگونه چهار مدل زبانی بزرگ مدرن در بازآفرینی یک کلاسیک ساده بازی ویندوزی عمل میکنند؟

ایدهی استفاده از هوش مصنوعی برای کمک به برنامهنویسی کامپیوتری به مسألهای بحثبرانگیز تبدیل شده است. از یک سو، عوامل کدنویسی میتوانند اشتباهات وحشتناکی مرتکب شوند که برای اصلاح آنها به نظارت انسانی ناکارآمد و زمانبر نیاز دارد و این باعث میشود بسیاری از توسعهدهندگان بهطور کامل اعتماد خود را به این مفهوم از دست بدهند. از سوی دیگر، برخی برنامهنویسان اصرار دارند که عوامل کدنویسی مبتنی بر هوش مصنوعی میتوانند ابزارهای قدرتمندی باشند و مدلهای پیشرفته به سرعت در برنامهنویسی بهبود مییابند بهگونهای که برخی از مشکلات رایج گذشته را رفع میکنند.

برای بررسی کارآیی ابزارهای برنامهنویسی هوش مصنوعی مدرن، تصمیم گرفتیم چهار مدل اصلی را با یک کار ساده آزمایش کنیم: بازآفرینی بازی کلاسیک ویندوزی Minesweeper. از آنجا که برای سیستمهای تطبیق الگو مانند مدلهای زبانی بزرگ، استفاده از کدهای موجود برای بازآفرینی بازیهای مشهور نسبتا آسان است، ما یک چالش نوآورانه نیز به آن اضافه کردیم.

دستور سادهٔ ما:

یک نسخهٔ کامل وب از Minesweeper با اثرات صوتی بسازید که

1) بازی استاندارد ویندوز را بازتولید کند و

2) ویژگی شگفتانگیز و سرگرمکنندهای برای گیمپلی پیادهسازی کند.پشتیبانی از صفحهلمس موبایل را نیز شامل شود.

بن ج ادوردز، ویرایشگر ارشد هوش مصنوعی Ars، این کار را به چهار عامل کدنویسی هوش مصنوعی با برنامههای ترمینال (خط فرمان) واگذار کرد: Codex از OpenAI مبتنی بر GPT‑5، Claude Code از Anthropic با Opus 4.5، Gemini CLI از Google، و Mistral Vibe. این عوامل سپس بهصورت مستقیم فایلهای HTML و اسکریپت را در یک ماشین محلی دستکاری کردند، بهوسیلهٔ یک مدل هوش مصنوعی «ناظر» که دستورات را تفسیر کرده و وظایف کدنویسی را به مدلهای موازی که میتوانند ابزارهای نرمافزاری را برای اجرای دستورها استفاده کنند، اختصاص داد. تمام برنامهریزیهای هوش مصنوعی بهصورت خصوصی و بدون دریافت دسترسی ویژهای از شرکتها پرداخت شد و شرکتها از این آزمایشها آگاه نبودند.

ویرایشگر ارشد بازیهای Ars (و کارشناس Minesweeper)، کایل اورلند، سپس هر مثال را بهصورت کور ارزیابی کرد، بدون این که بداند کدام مدل هر کلون Minesweeper را تولید کرده است. آن نتایج نسبتا ذهنی و غیررسمی در ادامه آمدهاند.

برای این آزمایش، ما کد غیرتغییری هر مدل هوش مصنوعی را در یک نتیجه «یکبارش» به کار بردیم تا ببینیم این ابزارها بدون نیاز به اشکالزدایی انسانی چقدر عملکرد دارند. در عمل، بیشتر کدهای تولید‑شده توسط هوش مصنوعی از یک سطحی از بازبینی و تنظیم توسط یک مهندس نرمافزار انسانی که میتواند مشکلات را شناسایی و ناکارآمدیها را رفع کند، عبور میکند.

ما این آزمایش را بهعنوان میانهای ساده برای وضعیت فعلی برنامهنویسی هوش مصنوعی انتخاب کردیم. کلونسازی Minesweeper کار سادهای نیست که فقط در چند خط کد قابل انجام باشد، اما همچنین یک سیستم فوقالعاده پیچیده نیست که به قطعات متحرک بسیاری نیاز داشته باشد.

Minesweeper همچنین یک بازی شناختهشده است که نسخههای متعددی در سراسر اینترنت مستند شدهاند. این باید به این عوامل هوش مصنوعی مواد خام کافی برای کار بدهد و برای ما ارزیابی آن راحتتر از یک ایدهٔ کاملاً جدید باشد. در عین حال، درخواست باز برای یک ویژگی جدید «سرگرمکننده» به ما این امکان را میدهد که تمایل هر عامل به «خلاقیت» برنامهنویسی بدون راهنمایی و تواناییاش برای افزودن ویژگیهای جدید بر روی یک مفهوم بازی ثابت را نشان دهیم.

پس از رفع تمام این موانع، در اینجا ارزیابی ما از کلونهای Minesweeper تولید شده توسط هوش مصنوعی، به همراه پیوندهایی که میتوانید برای بازی کردن آنها استفاده کنید، آورده شده است.

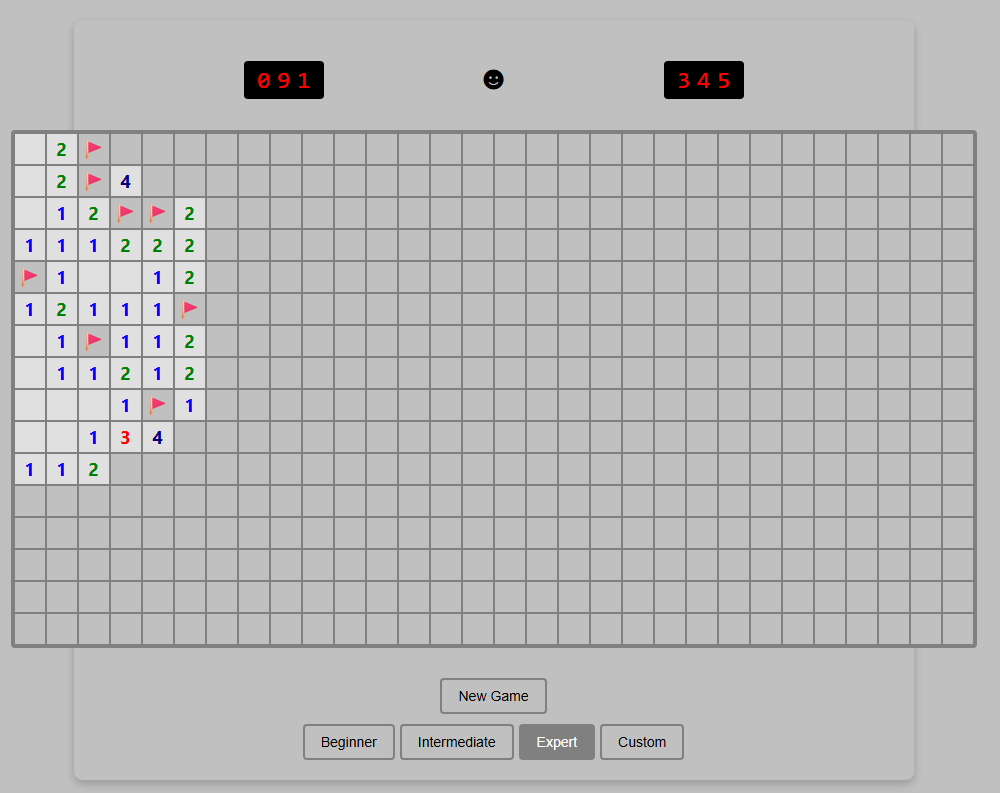

عامل ۱: Mistral Vibe

برای خودتان بازی کنید

پیادهسازی

در ابتدا، این نسخه به دلیل عدم پیادهسازی «چوردینگ»—تکنیکی که بازیکنان پیشرفتهٔ Minesweeper برای پاکسازی سریع تمام خانههای اطراف یک عدد که پیش از آن مینهای پرچمگذاری شده کافی دارد—امتیازهای خود را از دست میدهد. بدون این ویژگی، این نسخه بیش از حد دستوپا و ناهماهنگ بهنظر میرسد.

همچنین کمی از وجود دکمهٔ «سفارشی» که بهنظر نمیرسد کاری انجام بدهد، گیج شدم. گویی مدل متوجه شد که اندازههای سفارشی در Minesweeper وجود دارد اما نتوانست این ویژگی نسبتاً پایه را پیادهسازی کند.

بازی در موبایل بهخوبی کار میکند، اما علامتگذاری یک خانه با پرچم نیازمند فشار طولانی دشوار روی یک مربع کوچک است که علاوه بر آن دستهبندیکنندههایی را فعال میکند که پاکسازی آنها دشوار است. بنابراین، این رابط کاربری موبایلی ایدهآل نیست.

ارائه

این تنها نسخهٔ کارکردنی بود که آزمودیم که صدا نداشت. این منطقی است، چون نسخهٔ اصلی ویندوزی Minesweeper نیز صدا نداشت، اما همچنان این حذف قابل توجهی است؛ زیرا درخواست صدا بهوضوح در دستور ذکر شده بود.

دکمهٔ تمامسیاه «صورتخندنده» برای شروع بازی کمی ناخوشایند است، در مقایسه با نسخهٔ زرد روشن که برای بازیکنان Minesweeper و کاربران ایموجی در سراسر جهان آشناست. و در حالی که این صورتخندنده با کلیک یک بازی جدید را آغاز میکند، یک دکمهٔ «بازی جدید» اضافه نیز بهدلیل نامعلومی فضا را اشغال میکند.

ویژگی «سرگرمی»

نزدیکترین موردی که بهعنوان ویژگی «سرگرمی» جدید در اینجا یافت، افزودن الگوی پسزمینهٔ رنگینکمان به شبکه هنگام تکمیل یک بازی بود. اگرچه این کار کمی طراوت به بازی موفق میآفریند، من انتظار بیشتری داشتم.

تجربه کدنویسی

بن ج اشاره کرد که از عملکرد خوب Mistral Vibe به عنوان یک مدل وزن باز، علیرغم عدم داشتن پشتوانه مالی بزرگ نسبت به سایر رقیبان، خوشش آمد. با این حال، نسبتاً کند بود (سومین سریعترین از میان چهار مدل) و نتیجهٔ نهایی چندان رضایتبخش نبود. در مجموع، عملکرد آن تاکنون نشان میدهد که با زمان و آموزش بیشتر، میتواند یک عامل کدنویسی بسیار توانمند در آینده ظاهر شود.

امتیاز کلی: 4/10

این نسخه بسیاری از اصول پایه را بهدرستی پیادهسازی کرد اما ویژگی چوردینگ را نادیده گرفت و در جزئیات کوچک ارائه و ویژگیهای «سرگرمی» عملکرد مناسبی نداشت.

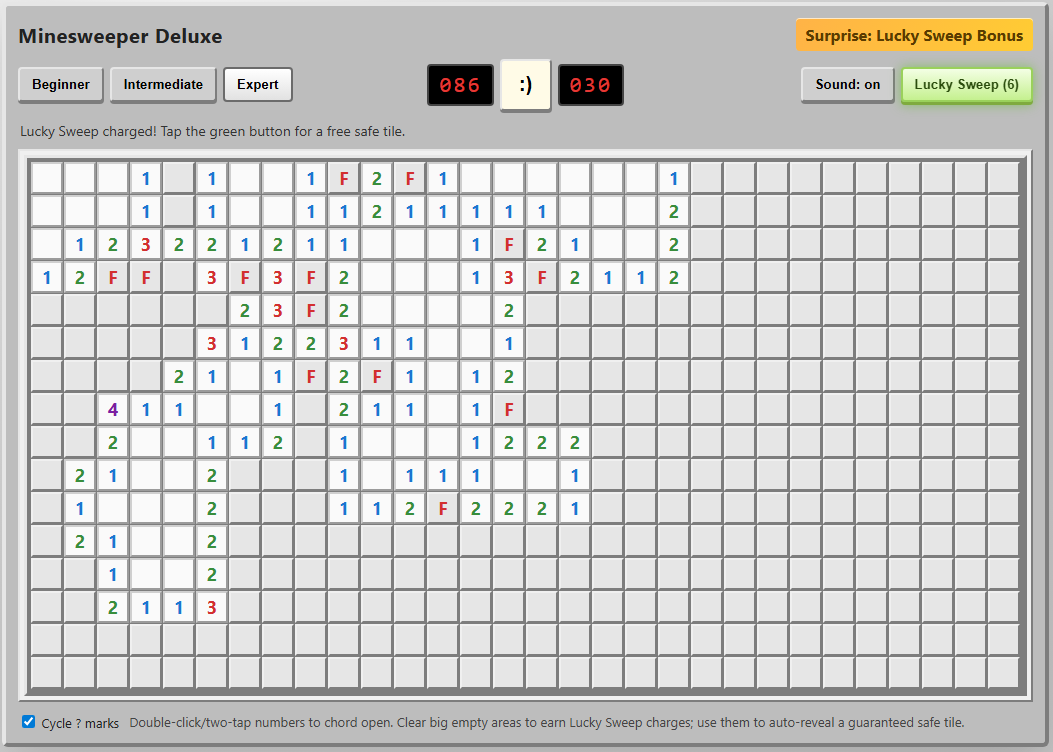

عامل ۲: OpenAI Codex

برای خودتان بازی کنید

پیادهسازی

نه تنها این عامل ویژگی حیاتی «چوردینگ» را گنجاند، بلکه دستورالعملهای رویصفحه برای استفادهٔ آن در مرورگرهای کامپیوتر و موبایل نیز ارائه داد. علاوه بر این، از گزینهٔ چرخش بین علامتهای «؟» هنگام علامتگذاری خانهها با پرچم بسیار تحت تأثیر قرار گرفتم؛ ویژگی خاصی که حتی اکثر کلونکنندگان انسانی Minesweeper ممکن است از دست بدهند.

در موبایل، گزینهٔ نگه داشتن انگشت روی یک خانه برای علامتگذاری پرچم یک لمس لطیف است که این نسخه را خوشایندترین نسخهٔ دستی که تست کردیم میسازد.

ارائه

دکمهٔ ایموجی صورتخندندهٔ سبک قدیمی، بهخوبی دلپذیر است، بهویژه هنگام بروز یک «X» با رنگ قرمز. من کمتر تحت تأثیر گرافیکهای صفحهٔ بازی شدم که از یک «*» ساده برای معادن کشفشده و یک «F» قرمز ناخوشایند برای خانههای پرچمدار استفاده میکنند.

اثرات صوتی بوق‑و‑بپ بازی مرا به اولین کامپیوتر قدیمم پیش از Sound‑Blaster در اواخر دههٔ ۸۰ میلادی یادآوری کرد. این بهطور کلی خوب است، اما همچنان از این که بازی گزینهٔ خاموش کردن صداها را فراهم میکند، قدردانی میکنم.

ویژگی «سرگرمی»

«سرگرمی: جایزهٔ خوششانس» که در گوشه رابط کاربری ذکر شده است، توضیح میدهد که کلیک کردن روی دکمه یک خانهٔ امن رایگان به شما میدهد وقتی در دسترس باشد. این میتواند در موقعیتهایی که مجبور به حدس زدن بین دو خانهای با احتمال مساوی برای داشتن مین هستید، مفید باشد.

بهطور کلی، با این حال، کمی عجیب بود که بازی این جایزه را تنها پس از یافتن یک میدان بزرگ از خانههای ایمن بهصورت زنجیرهای با یک کلیک به شما میدهد. این بیشتر بهعنوان یک دکمهٔ «برد بیشتر» عمل میکند تا ویژگیای که تعادل مناسبی بین ریسک و پاداش فراهم کند.

تجربه کدنویسی

OpenAI Codex دارای یک رابط ترمینال زیبا با ویژگیهایی مشابه Claude Code (دستورات محلی، مدیریت دسترسیها، و انیمیشنهای جذاب نشاندهندهٔ پیشرفت) است و استفاده از آن نسبتاً دلپذیر میباشد (OpenAI همچنین Codex را از طریق یک رابط وب در اختیار میگذارد، اما ما برای این ارزیابی از آن استفاده نکردیم). با این حال، Codex حدوداً دو برابر زمان Claude Code برای نوشتن یک بازی کاربردی صرف کرد، که شاید به نتایج قوی اینجا کمک کرده باشد.

امتیاز کلی: 9/10

پیادهسازی چوردینگ و جزئیات جذاب ارائه این نسخه را به صدر فهرست میبرد. فقط آرزو داشتیم که ویژگی «سرگرمی» کمی جذابتر باشد.

عامل ۳: Anthropic Claude Code

برای خودتان بازی کنید

پیادهسازی

دوباره، یک نسخه دریافت کردیم که تمام اصول پایهٔ گیمپلی را بهدرستی پیادهسازی میکند اما ویژگی حیاتی «چوردینگ» را از دست داده است. این شبیه بازی Super Mario Bros. بدون دکمهٔ دویدن یا Ocarina of Time بدون هدفگیری Z‑است؛ بهعبارت دیگر: غیرقابل قبول.

دکمهٔ «حالت پرچم» در نسخهٔ موبایل این بازی بهطور کامل کار میکند، اما استفاده از آن کمی دستوپا است. همچنین، بصورت بصری بخشی از صفحهٔ بازی را در اندازههای بزرگتر قطع میکند.

ارائه

از نظر ارائه، این احتمالاً براقترین نسخهای است که تست کردیم. از استفاده از ایموجیهای بامزه برای دکمهٔ صورتخندنده تا گرافیکهای زیبا برای بمب و پرچم و صداهای ساده اما مؤثر، این نسخه شفافتر و حرفهایتر بهنظر میرسد.

اگرچه، برخی مشکلات عجیب در ارائه وجود دارد. بهعنوان مثال، شبکهٔ «beginner» فواصل عجیبی بین ستونها دارد. همچنین، مرزهای هر خانه و گرافیک پرچم میتوانند بهطرز عجیبی خاکستری شوند، بهویژه هنگام استفاده از حالت Power (مطابق زیر).

ویژگی «سرگرمی»

دکمهٔ برجستهٔ «Power Mode» در گوشهٔ پایین‑راست برخی توانمندیهای جالب را ارائه میدهد که فرمول اصلی Minesweeper را بهصورت جالبی تغییر میدهند. با این حال، این توانمندیها تا حدودی ناموفق هستند.

بهویژه توان «Shield» که از یک حدس اشتباه محافظت میکند و توان «Blast» که بهنظر میرسد یک زنجیرهٔ بزرگ از خانههای کشفشده را در هر کلیک تضمین میکند، مورد تعجبم بود. اما توان «X‑Ray» که برای چند ثانیه تمام بمبها را نشان میدهد، میتواند بهراحتی توسط بازیکن ماهر (یا اسکرینشات دقیق) سوءاستفاده شود. و توان «Freeze» کمی کسلکننده است؛ فقط ساعت را برای چند ثانیه متوقف میکند و بهصورت افزودن زمان اضافی عمل میکند.

بهطور کلی، بازی این توانمندیهای جدید را مانند آبنبات توزیع میکند، که باعث میشود حتی تختهٔ سطح Expert نسبتاً ساده شود وقتی «Power Mode» فعال باشد. همچنین انتخاب «Power Mode» بهنظر میرسد بلافاصله پس از شروع بازی چند خانهٔ امن را علامتگذاری کند و کار را حتی راحتتر سازد. بنابراین، اگرچه این توانمندیها میتوانند «سرگرمکننده» باشند، اما تعادل آنها بهخوبی برقرار نیست.

تجربه کدنویسی

از میان چهار مدل آزمایششده، Claude Code با Opus 4.5 بهترین تجربهٔ رابط ترمینال را ارائه داد و سریعترین زمان کلی برای ساخت یک Minesweeper را داشت (Claude Code میتواند از Sonnet 4.5 که حتی سریعتر است، استفاده کند، اما در تجربهٔ ما نتایج کاملتری ارائه نداد). اگرچه دقیقاً زمانگذاری هر مدل انجام نشد، Opus 4.5 یک بازی Minesweeper را در کمتر از پنج دقیقه ساخت. Codex حداقل دو برابر زمان طول کشید، در حالی که Mistral تقریباً سه یا چهار برابر زمان Claude Code صرف کرد. Gemini، از سوی دیگر، ساعتها وقت صرف کرد تا دو نتیجهٔ غیرقابل اجرا به دست آورد.

امتیاز کلی: 7/10

عدم وجود چوردینگ نقص بزرگی است، اما ارائه قوی و گزینههای Power Mode این تلاش را به امتیاز قابل قبولی میرسانند.

عامل ۴: Google Gemini CLI

برای خودتان بازی کنید

پیادهسازی،ارائه، و غیره.

Gemini CLI چند جعبهٔ خاکستری که میتوانید کلیک کنید به ما داد، اما میدانهای بازی موجود نبودند. اگرچه رفع مشکل بهصورت تعاملی با عامل میتوانست این مسأله را حل کند، در آزمون «یکبار» مدل کاملاً شکست خورد.

تجربه کدنویسی

از میان چهار عامل کدنویسی که آزمایش کردیم، Gemini CLI بیشترین دردسر را برای بن ج ایجاد کرد. پس از توسعهٔ یک طرح، تولید هر کد قابل استفادهای بسیار، بسیار کند بود (حدود یک ساعت برای هر تلاش). این مدل بهنظر میرسید هنگام تلاش برای ساخت دستی اثرات صوتی WAV گیر میکرد و بر نیاز به کتابخانههای خارجی React و چند وابستگی پیچیده دیگر اصرار داشت. نتیجه بهسادگی کار نکرد.

بن ج در واقع قوانین را کمی زیر پا گذاشت و به Gemini فرصت دوم داد، با این شرط که بازی از HTML5 استفاده کند. وقتی مدل دوباره شروع به نوشتن کد کرد، همچنین در ساخت اثرات صوتی گیر کرد. بن ج پیشنهادی برای استفاده از چارچوب WebAudio داد (که سایر عوامل کدنویسی هوش مصنوعی قادر به استفاده از آن بودند)، اما نتیجه کار نکرد؛ میتوانید این را در لینک بالا مشاهده کنید.

بر خلاف سایر مدلهای تستشده، Gemini CLI ظاهراً از یک سیستم ترکیبی شامل سه مدل زبانی مختلف برای وظایف متفاوت استفاده میکند (Gemini 2.5 Flash Lite، 2.5 Flash و 2.5 Pro در سطح حساب Google که بن ج برای آن پرداخت، در دسترس بودند). پس از اتمام جلسهٔ کدنویسی و خروج از رابط CLI، یک گزارش از اینکه کدام مدل چه کاری انجام داده است، به شما نمایش میدهد.

در این مورد، مهم نبود چون نتایج کار نکردند. اما شایان ذکر است که مدلهای کدنویسی Gemini 3 برای سایر طرحهای اشتراکی که در اینجا تست نشدند، در دسترس هستند. به همین دلیل، این بخش از آزمایش میتواند بهعنوان «نامکمل» برای Google CLI در نظر گرفته شود.

امتیاز کلی: 0/10 (ناقص)

نتیجهگیری نهایی

OpenAI Codex در این رقابت از لحاظ امتیاز برنده شد، چرا که تنها مدلی بود که چوردینگ را بهعنوان گزینهای در گیمپلی گنجانده بود. اما Claude Code نیز با ارائه جزئیات قوی و زمان تولید سریع خود متمایز شد. Mistral Vibe گامی مهم پایینتری بود، و Google CLI مبتنی بر Gemini 2.5 کاملاً در آزمون یکبار ما شکست خورد.

در حالی که برنامهنویسان باتجربه میتوانند با گفتوگوهای تعاملی و باز میان خود و یک عامل، نتایج بهتری بگیرند، این نتایج نشان میدهند که حتی با یک درخواست کوتاه برای یک کار نسبتاً ساده، برخی از این مدلها میتوانند بسیار توانمند باشند. با این وجود، تجربهٔ کلی ما از عوامل کدنویسی در پروژههای دیگر (در مقالهٔ آینده) بهطور کلی ایدهٔ این را تقویت میکند که در حال حاضر این ابزارها بهعنوان ابزارهای تعاملی که مهارت انسانی را تقویت میکنند، بهتر از آنکه جانشین آن شوند.